刚刚!微博宣布了自研模型:1.5B参数的VibeThinker打败671B的DeepSeek R1? 原创

这是一个关于"小个子选手"在AI竞技场上战胜"巨人"的精彩故事。2025年11月,来自新浪微博公司的研究团队发表了一篇技术报告,介绍了他们开发的VibeThinker-1.5B模型。这篇论文发布在arXiv预印本平台上,引起了AI研究界的广泛关注。

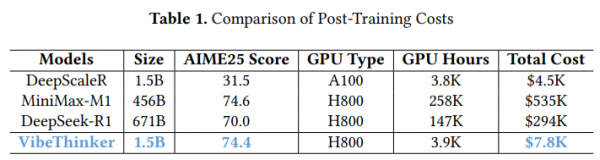

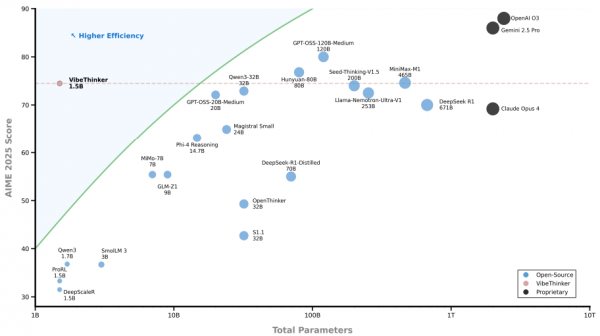

一个只有15亿参数的小模型,竟然在多项复杂的数学和编程测试中击败了拥有6710亿参数的DeepSeek R1模型,后者的体积是前者的400多倍!更令人惊讶的是,训练这个小模型的总成本只有7800美元,而那些大模型的训练成本动辄数十万美元。

长期以来,AI界有一个被广泛接受的共识:想要让模型变得更聪明,就必须把它做得更大。就像盖房子一样,想要房子更豪华,就得用更多的材料、更大的空间。按照这个逻辑,那些拥有数千亿参数的超大模型理应在各种任务上碾压小模型。但VibeThinker的出现打破了这个认知,它证明了通过精巧的训练方法,小模型也能拥有媲美甚至超越大模型的推理能力。

这个发现意味着它大幅降低了AI研究和应用的门槛。如果小模型就能解决问题,那么普通大学、中小企业甚至个人开发者都有机会参与到AI创新中来,而不是只有谷歌、OpenAI这样的科技巨头才能玩得起。其次,小模型的推理速度更快、能耗更低,可以部署在手机、汽车这样的边缘设备上,让AI真正走进千家万户。最后,这项研究挑战了"大即是好"的简单粗暴思维,提醒我们:有时候,聪明的方法比蛮力更重要。

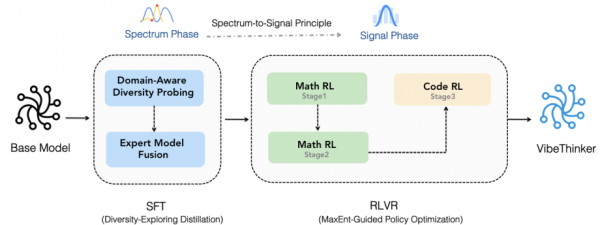

研究团队的核心创新在于提出了一个叫做"频谱到信号原理"(Spectrum-to-Signal Principle,简称SSP)的训练框架。这个听起来有点学术的名字,其实可以用一个简单的比喻来理解。想象你正在调试一台收音机:第一步是旋转旋钮,让收音机接收到尽可能多的频段信号,这就像是"频谱阶段",目标是增加多样性;第二步是锁定清晰度最好、内容最有价值的那个频道,这就是"信号阶段",目标是找到最佳答案。传统的训练方法往往只关注第二步,而VibeThinker创新性地强调了第一步的重要性:只有先拥有丰富的"频谱",才能找到最强的"信号"。

现在让我们深入探讨VibeThinker是如何做到这一切的。

核心训练理念:为什么多样性比单一正确答案更重要?

传统的AI训练方法有点像应试教育:给模型一道题,告诉它标准答案,然后让它反复练习直到每次都能答对。这种方法的问题在于,模型可能只学会了一种解题套路,遇到稍微不同的题目就懵了。VibeThinker的训练理念完全不同,它更像是素质教育:鼓励模型探索多种解题思路,即使这些思路一开始不那么完美。

用一个烹饪的比喻来解释这个理念会更清楚。假设你想学做一道菜,比如宫保鸡丁。传统方法就是给你一个标准菜谱,让你严格按照步骤操作,每次都追求做出和范例一模一样的味道。而VibeThinker的方法是:第一步,尝试各种不同的做法,有的人多放辣椒,有的人多放花生,有的人用鸡胸肉,有的人用鸡腿肉;第二步,品尝所有这些不同版本,找出最好吃的几种,然后总结它们的共同特点和成功要素。通过这个过程,你不仅学会了做宫保鸡丁的标准方法,还理解了这道菜的核心原理,以后碰到类似的菜也能举一反三。

研究团队把这个理念总结为"频谱到信号原理"。在第一阶段(监督微调),他们不追求模型的单次答题准确率(Pass@1),而是优化一个叫Pass@K的指标。这个指标的意思是:给模型一道题,让它生成K个不同的答案,只要这K个答案中至少有一个是对的,就算成功。这样做的好处是,模型学会了从多个角度思考问题,建立起了一个丰富的"解题方案库"。在第二阶段(强化学习),模型就可以从这个方案库中筛选和强化那些真正有效的方法。

为什么这种方法对小模型特别重要?因为小模型的参数少,"脑容量"有限,必须用最高效的方式学习。如果只是死记硬背标准答案,小模型很快就会"脑子装满",无法应对新问题。但如果让它学会了多样化的思考方式,它就能用有限的参数做更多的事情。这就像是一个人虽然记忆力不如别人,但思维灵活、善于举一反三,照样能在考试中取得好成绩。

两阶段多样性探索蒸馏:如何教会模型多角度思考?

VibeThinker训练的第一阶段叫做"两阶段多样性探索蒸馏",听起来很复杂,但用一个简单的比喻就能说清楚。想象你是一位武侠小说里的掌门,要培养一个弟子成为绝世高手。你手下有四位师傅,分别精通剑法、刀法、拳法和掌法。你的目标是让弟子学会各家之长,成为一个全能型选手。你会怎么做?

第一步,你让弟子分别跟四位师傅学习,每个师傅只教自己最擅长的那一套。这就是"领域感知多样性探测"阶段。研究团队把数学问题分成了四个子领域:代数、几何、微积分和统计。对于每个子领域,他们让模型在训练过程中定期停下来接受测试,看看它在生成多样化答案方面的表现如何。每个子领域都会找出一个"最擅长生成多样化答案"的模型版本,就像是找出了四位"专家"。

第二步,你让弟子把四位师傅教的东西融会贯通,形成自己独特的武功体系。这就是"专家模型融合"阶段。研究团队把四个专家模型的参数进行了线性融合,简单说就是把它们的"技能"平均混合在一起。最终得到的模型既会代数的多种解法,也会几何的多种思路,还懂微积分和统计的各种技巧。这个融合后的模型就成了第一阶段的输出,它的特点是"知识面广、思路灵活"。

有趣的是,研究团队发现,这个经过多样性优化的模型不仅Pass@K指标高(意味着它能生成很多正确答案),Pass@1指标也不低(意味着它单次答题的准确率也不差)。这说明多样性和准确性并不矛盾,反而是相辅相成的。就像一个真正的武林高手,不仅招式多变,每一招的威力也不弱。

这种训练方法还有一个额外的好处:它能帮助研究团队发现模型的薄弱环节。如果某个子领域的多样性表现一直不好,说明模型在这个领域的理解还不够深入,需要针对性地加强训练。这就像是找到了学生的"偏科"问题,然后有针对性地辅导。

最大熵引导策略优化:如何让模型学会挑选最佳答案?

经过第一阶段的训练,模型已经学会了生成多样化的答案,但还不太会判断哪个答案最好。这就像是一个厨师学会了做菜的各种技巧,但还不太确定哪种做法能让顾客最满意。第二阶段的训练就是要解决这个问题,研究团队使用的方法叫做MGPO(最大熵引导策略优化)。

要理解MGPO,我们先来玩一个猜硬币的游戏。我手里有一枚硬币,多次抛掷后,你需要猜测它是正面朝上还是反面朝上。如果我告诉你"这枚硬币100次抛掷中有100次都是正面",你会很有把握地猜"正面",因为这个硬币的行为非常确定。如果我告诉你"100次中有50次正面,50次反面",你就完全没把握了,因为这个硬币的行为充满了不确定性。在信息论中,我们用"熵"这个概念来衡量不确定性,50-50的情况就是"最大熵"状态。

MGPO的核心思想是:那些让模型处于"最大熵"状态的题目,也就是模型"拿不准"的题目,才是最有训练价值的。想想看,如果一道题模型已经能100%答对了,反复训练它也学不到什么新东西;如果一道题模型怎么都答不对,可能是因为这道题超出了它的能力范围,训练效果也不好。只有那些模型"半懂不懂"的题目,有时能答对,有时答不对,才是最好的学习材料,因为这些题目正好处在模型能力的边界上,稍加训练就能有突破。

具体操作是这样的:研究团队让模型对每道题生成多个答案,然后计算正确答案的比例。如果这个比例接近50%,说明模型对这道题的把握度正好在"不确定"的状态,就给这道题更高的训练权重;如果比例接近0%或100%,说明模型要么完全不懂,要么已经完全掌握,就降低训练权重。这种动态调整训练重点的方法,让模型总是在最需要提升的地方下功夫。

用学习的比喻来说,MGPO就像是一个智能的私人教师。它会根据学生的表现动态调整教学内容:学生已经掌握的知识就少讲,学生完全不懂的知识就暂时放一放,重点讲那些学生"似懂非懂"的内容。这样的教学效率最高,学生进步最快。

研究团队还做了一个巧妙的设计:在MGPO训练中,他们特别奖励那些"低概率但正确"的答案。什么意思呢?假设模型对一道题生成了十个答案,其中九个是错的,只有一个是对的,而且这个对的答案非常罕见。MGPO会特别强化这个罕见答案的生成概率,因为它代表了模型"灵光一现"的正确思路。通过不断强化这些"灵光一现"的时刻,模型就能逐渐提高在困难问题上的表现。这有点像是培养创新思维:不是让人总是按部就班地解题,而是鼓励那些偶尔出现的、非常规但有效的解题思路。

整个第二阶段的训练分成了三个小步骤。首先是在16K上下文长度(可以理解为题目的复杂程度)下进行数学推理训练;然后扩展到32K上下文长度,处理更复杂的数学问题;最后是编程任务的训练。这种循序渐进的方式,确保了模型在每个阶段都能充分吸收知识,不会因为难度跳跃太大而"消化不良"。

数据处理与成本控制:如何用有限资源达到最佳效果?

VibeThinker的成功不仅在于训练方法的巧妙,还在于对数据的精心处理和对成本的严格控制。这两个方面往往被忽视,但对于小模型来说却至关重要。

首先是数据去污染问题。什么是数据污染?想象你在准备考试,考试题目恰好是你平时练习过的原题,那你考高分就不稀奇了,因为这不能真实反映你的能力。AI模型也一样,如果训练数据中混入了测试题目的答案,模型在测试时的好成绩就是虚假的。研究团队非常重视这个问题,他们使用了一种叫"10-gram匹配"的技术来识别和剔除可能与测试集重复的训练数据。这个技术的原理是:把文本分成每10个词一组的片段,如果训练数据中有片段和测试数据高度相似,就认为存在污染风险,将其删除。

这里有一个有趣的争议。有研究者质疑说,某些模型(比如VibeThinker的基础模型Qwen2.5-Math-1.5B)可能本身就存在数据污染,所以才能在某些测试上表现不错。但研究团队用两个事实反驳了这种质疑。第一,基础模型在AIME24、AIME25这些测试上的得分非常低(分别只有6.7和4.3分),如果真的存在数据污染,不应该这么差。第二,VibeThinker在2025年才发布的全新测试集(如AIME25和HMMT25)上表现优异,而这些测试集的题目不可能在2024年发布的基础模型训练数据中出现。这就像是一个学生在旧版教材的题目上做得不好,但在全新出版的试卷上反而考得很好,显然不是因为提前知道了答案,而是真正学会了知识。

其次是成本控制。训练一个AI模型就像建造一座大楼,需要大量的计算资源。VibeThinker的训练总共用了3900个GPU小时,使用的是NVIDIA H800这种高性能显卡。按照市场价格每GPU小时2美元计算,总成本不到8000美元。相比之下,DeepSeek R1的训练成本是29.4万美元,MiniMax-M1的成本更是高达53.5万美元。VibeThinker的成本只有它们的三十分之一到六十分之一。这种巨大的成本差异,主要来自于模型规模的差异,小模型需要的计算资源少得多。

但便宜不意味着偷工减料。研究团队在有限的预算内做到了精打细算。他们使用的训练数据大部分来自公开数据集,只有小部分是自己合成的专业数据。这就像是做菜时,大部分食材从市场买,只有关键调料自己特制。这种"开源为主、自研为辅"的策略,既保证了数据质量,又大幅降低了数据准备的成本。

最后值得一提的是推理成本。训练只是一次性投入,而推理(也就是实际使用模型)是持续性的开销。小模型的推理速度快、能耗低,可以部署在手机、汽车等边缘设备上,不需要连接云端服务器。研究团队估算,VibeThinker的推理成本是那些大模型的二十分之一到七十分之一。这意味着,如果一个应用服务每天要处理一百万次查询,使用VibeThinker可以节省数万美元的运营成本。

测试结果:小个子选手如何在各项竞赛中崭露头角?

说了这么多训练方法,最关键的问题来了:VibeThinker的实际表现到底如何?研究团队在多个极具挑战性的测试集上进行了评估,结果令人印象深刻。

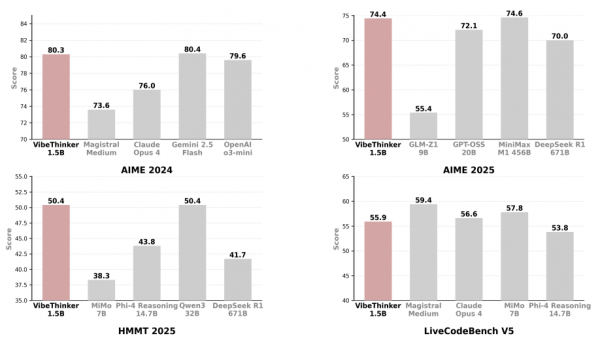

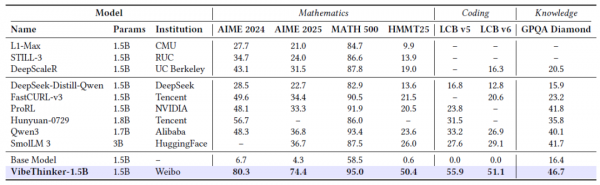

我们先来看数学测试。AIME(美国数学邀请赛)是一项面向高中生的高难度数学竞赛,只有在AMC(美国数学竞赛)中得分最高的学生才有资格参加。AIME的题目涵盖代数、几何、数论等多个领域,需要深入的数学理解和巧妙的解题技巧。在AIME 2024测试中,VibeThinker的得分是80.3分(满分150分),超过了DeepSeek R1的79.8分。要知道,DeepSeek R1是一个6710亿参数的巨型模型,体积是VibeThinker的447倍!在AIME 2025测试中,VibeThinker得分74.4分,比DeepSeek R1的70.0分高出4.4分。这就像是一个体重50公斤的拳击手击败了一个200公斤的对手。

更有说服力的是HMMT(哈佛麻省理工数学锦标赛)2025的结果。HMMT是全球顶尖的高中数学竞赛之一,难度极高。VibeThinker在这项测试中得分50.4分,而DeepSeek R1只有41.7分。这个差距已经不是"险胜",而是"明显优势"了。研究团队还对比了其他一些大模型的表现,比如Phi-4 Reasoning(147亿参数)得分43.8,Magistral Small(240亿参数)得分43.5,都不如VibeThinker。这充分说明,在逻辑推理任务上,模型的"智商"不完全取决于"体重"。

在编程测试上,VibeThinker也表现不俗。LiveCodeBench是一个评估AI编程能力的基准测试,题目来自实际的编程竞赛网站,包括算法设计、代码实现、调试等多个方面。在LiveCodeBench V6测试中,VibeThinker得分51.1分,略微超过了商业模型Magistral Medium的50.3分。考虑到VibeThinker的基础模型在编程任务上完全不行(得分0分),这个提升可以说是质的飞跃。这就像是一个从来没学过编程的人,通过系统训练成为了合格的程序员。

不过,研究团队也坦诚地指出了VibeThinker的局限性。在GPQA(研究生级别问答)测试中,VibeThinker的得分只有46.7分,而那些大模型的得分普遍在70-80分之间。GPQA的题目涉及物理、化学、生物等多个领域的专业知识,需要模型拥有广博的知识储备。在这种任务上,小模型的劣势就显现出来了,它的"脑容量"有限,无法记住所有领域的所有知识。这就像是让一个小背包和一个大行李箱比谁装的东西多,小背包肯定是比不过的。

但即便如此,VibeThinker在GPQA上的表现也超过了它的基础模型(16.4分),提升了30多分。这说明通过精心的训练,即使是小模型也能在知识密集型任务上有所进步。研究团队呼吁学界重视提升小模型的通用知识能力,因为这是小模型真正走向实用化的关键瓶颈。

从成本效益的角度来看,VibeThinker的性价比简直爆表。它用不到8000美元的训练成本,达到了那些花费数十万美元训练的大模型的水平。如果把训练成本和性能画成一张图,VibeThinker无疑是位于"高性价比"区域的明星选手。这种效率优势,对于预算有限的研究团队和企业来说,具有巨大的吸引力。

技术细节:给开发者的一些启示

VibeThinker的成功不是偶然的,它背后有许多值得学习的技术细节。这些细节虽然专业,但我们可以用通俗的方式理解它们的价值。

首先是模型融合技术。在第一阶段训练中,研究团队得到了四个专家模型,分别擅长不同的数学子领域。如何把它们合并成一个统一的模型呢?最简单的方法是"平均融合",就是把四个模型的参数直接平均。研究团队采用的就是这种方法,每个专家模型占25%的权重。这种方法简单有效,就像是做果汁时把四种水果等量混合,既保留了每种水果的味道,又创造了一种全新的口感。

其次是采样策略。在测试时,VibeThinker对每道题会生成多个答案,然后从中选择最好的一个。这个过程用到了一种叫"核采样"(nucleus sampling)的技术,参数top_p设置为0.95。这个技术的原理是:模型生成每个词时,不是简单地选择概率最高的词,而是从概率累计达到95%的词中随机选择。这样做的好处是,既保证了生成内容的合理性,又引入了一定的随机性,避免答案过于死板。数学任务的采样温度设为1.0,编程任务设为0.6,温度越高,随机性越大,创造性越强;温度越低,答案越确定,稳定性越好。

再次是多阶段训练策略。VibeThinker的训练不是一蹴而就的,而是分成了多个阶段:先做16K上下文的数学训练,再做32K上下文的数学训练,最后做编程训练。这种循序渐进的方式,确保了模型在每个阶段都能充分学习,不会因为任务突然变难而"学不会"。这就像是健身时先做轻重量训练,再逐渐加重,最后挑战大重量,而不是一上来就举最重的杠铃。

最后是评估方法。研究团队在评估时采用了Pass@K的方法,具体来说就是让模型对每道题生成K个答案,只要其中有一个正确就算通过。数学任务K设为64,编程任务K设为8。为什么不同任务的K值不一样?因为数学题往往有多种解法,生成64个答案能更好地展现模型的多样性;而编程题的正确答案相对唯一,生成8个就足够了。这种灵活的评估方法,既全面又高效。

这些技术细节看似琐碎,但正是它们的精妙配合,才成就了VibeThinker的优异表现。对于AI开发者来说,这些经验都是宝贵的参考。

VibeThinker的故事告诉我们:在AI的世界里,"大"不一定等于"强"。通过精巧的训练方法、合理的资源分配和对问题本质的深刻理解,小模型也能拥有媲美甚至超越大模型的能力。这不仅是技术上的突破,更是理念上的创新,它提醒我们,不要迷信规模,而要追求效率;不要依赖蛮力,而要发挥巧劲。

当然,VibeThinker也并非完美无缺。它在通用知识任务上的表现仍然落后于大模型,这说明小模型还有很长的路要走。但这项研究已经证明,小模型的潜力远比我们想象的大。未来的AI发展,可能不再是一味追求"更大更强",而是在"大小结合、各展所长"的方向上百花齐放。大模型继续在知识密集型任务上发挥优势,小模型则在逻辑推理、实时应用、边缘部署等场景大显身手。两者携手,共同推动AI技术造福人类。

这个"小个子选手"的逆袭故事,让我们看到了AI民主化的希望。不是只有科技巨头才能玩转AI,不是只有天文数字的投入才能做出好模型。只要有聪明的想法、扎实的技术和对问题的深刻洞察,即使资源有限,也能创造出令人惊叹的成果。VibeThinker用实际行动告诉我们:在AI的世界里,真正重要的不是"块头"有多大,而是"脑子"有多灵。

END

Q&A

Q1:VibeThinker-1.5B会不会取代那些大型AI模型?

A:不会完全取代,但会在某些场景下成为更好的选择。VibeThinker在逻辑推理和编程任务上表现优异,适合部署在手机、汽车等边缘设备上,成本也低得多。但在需要广博知识的任务上,大模型仍有优势。未来可能是大小模型各司其职,而不是一方取代另一方。

Q2:普通人能用上VibeThinker吗?

A:研究团队已经在GitHub和HuggingFace上开源了VibeThinker的模型权重,技术人员可以免费下载使用。虽然目前还没有面向普通用户的应用产品,但随着技术的推广,未来很可能会有基于VibeThinker的消费级应用出现,比如智能学习助手、编程辅导工具等。

Q3:VibeThinker的训练方法可以用在其他AI模型上吗?

A:完全可以!研究团队提出的"频谱到信号原理"和MGPO方法是通用的训练框架,不限于特定模型。其他研究者可以把这套方法应用到自己的模型上,可能也会取得类似的效果提升。这也是研究团队开源模型和方法的初衷——推动整个AI社区的进步。

来源:至顶AI实验室

好文章,需要你的鼓励

香港大学团队重磅突破:让AI画图速度提升4倍的神奇“降噪魔法“

香港大学联合多家顶尖机构开发出推测性雅可比降噪解码技术,巧妙融合扩散模型降噪与自回归并行处理,将AI图像生成速度提升2-5倍。该方法通过训练模型处理噪声输入并预测干净标记,实现多位置同时生成,在保持图像质量的同时大幅缩短等待时间,为AI创作应用带来革命性改善。

Google推出类似苹果私有云计算的AI隐私保护技术

谷歌推出类似苹果私有云计算的新平台,让用户在享受先进AI功能的同时保护数据隐私。该平台将复杂AI请求转移到云端处理,确保敏感数据仅用户可见,连谷歌也无法访问。随着AI工具需要更强计算能力,这一方案平衡了隐私保护与性能需求。Pixel 10手机将获得更智能的Magic Cue建议和更多语言的录音转录功能。

韩国大学团队破解AI绘画“胡言乱语“难题:让机器画出更真实的图像

韩国大学等机构研究团队提出TAG方法,解决AI绘画中的"幻觉"问题。该方法通过放大扩散过程中的切线分量来引导AI生成更真实图像,无需重训练模型且计算成本极低。实验显示TAG能显著改善图像质量,减少不合理细节如多指手等,同时可与现有引导技术结合使用,为AI绘画领域提供了简单有效的优化方案。

思科人工智能研究:97%的AI领导者实现规模化价值 基础设施决策成就领先优势

出海马来西亚建厂惊魂记

李彦宏:当AI被真正内化,生产力革命才真正开始

Dell PowerProtect助力企业构建更高效、更智能的网络弹性

Google推出类似苹果私有云计算的AI隐私保护技术

OpenAI GPT-5.1模型全面升级:个性化交互与推理能力双提升

思科AI基础设施布局获回报,财报超预期股价大涨

1Password新增自动解锁功能:Mac登录时可同步解锁密码库

微软启动跨洲数据中心超级集群项目,连接千里距离训练超大参数AI模型

工程师变身AI“指挥者”,吉利与阿里云的软件开发变革实验

IBM发布Loon和Nighthawk量子处理器推进容错计算

VDURA数据平台推出快照和SMR支持功能,助力扩展性和成本优化