学霸还是学渣,数学能力训练到底提升了什么?深度揭秘大模型能力迁移的秘密 原创

我们从小就知道一句至理名言,“学好数理化,走遍天下都不怕”,并且深以为然…

每年高考报志愿,基本都是文科生最失落的时候,大部分专业基本都是只对理科开放,而毕业后,理科生的就业压力也远远低于文科,可见,在现在这个社会,无论学习研究,还是日常工作,大家基本形成了一个或许并不正确的共识,数理化的能力基本意味着个人能力。

同理,这种共识也用到了AI研发上…

数学推理,一直以来都被认为是衡量大模型能力的一个重要因素,AIME(美国数学邀请赛)的题库更是成为了几乎所有大模型的评测数据集,你如果没在AIME的题目上得个八九十分貌似都不好意思发布。

但,这种共识是错误的,数学能力并不等于通用能力,无论是对于人,还是模型…

最近,卡内基梅隆大学发布了他们的一项最新研究,他们对20多个开源推理模型进行了后训练,涵盖数学推理、科学问答、代码生成、指令遵循等多个维度,最终发现,数学能力优异的模型,在其他任务上表现平平,甚至还不如未加强数学推理能力的原始模型。

研究背景:来自顶尖团队的深入探索

这项研究由卡内基梅隆大学主导,联合了宾夕法尼亚大学、华盛顿大学、香港理工大学等多所知名院校。论文在2025年7月发表在arXiv平台上,是一项关于大语言模型推理能力迁移性的重要研究。

研究团队的背景相当扎实,主要研究人员都在自然语言处理和机器学习领域有深厚造诣,同时,这项工作得到了卡内基博世研究院(Carnegie Bosch Institute)的支持。

研究的出发点也明确,当前的AI社区几乎每周都会有新的模型推出,在MATH、AIME等标准测试集上的表现不断刷新记录,一些模型甚至超越了人类专家的水平。这些获取数学高分的进展是否真代表了AI能力的提升,还是仅仅是在特定任务上的过度优化?

核心成果:RL,通往“全能学霸”的关键路径

这项研究的核心发现,可以用一句话概括:数学能力与通用能力并不成正比,不同的训练范式,直接决定了模型的数学能力是否可以延伸到通用能力上”。

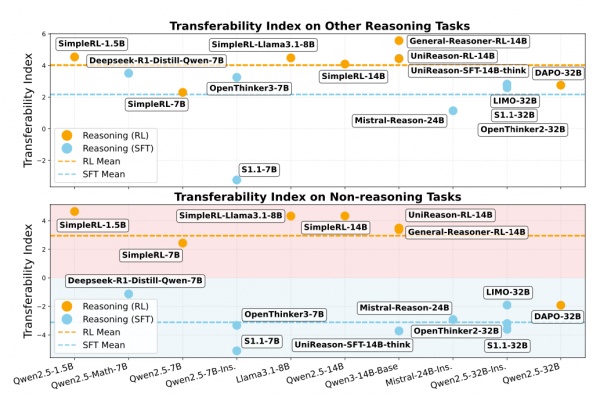

研究团队提出了一个量化指标叫做"迁移性指数",用来衡量模型从数学推理到其他任务的能力迁移程度。

它比较模型在数学任务上的提升幅度与在其他任务上的表现变化,如果一个模型在数学上提升了30%,在其他推理任务上也提升了30%,那么它的迁移性指数就是100%,表示完美迁移。

研究团队对20个数学能力优异的开源推理模型进行了深入分析与后训练,发现,不同的训练方法导致了截然不同的能力迁移效果。

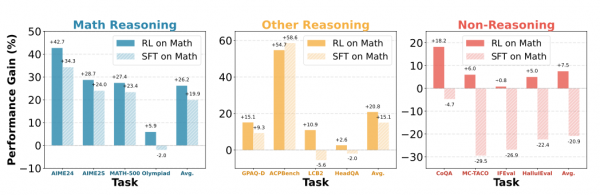

使用监督微调(SFT)训练的模型,虽然在数学推理上表现优异,但在非推理任务上的表现大幅下降,有些模型的迁移性指数甚至是负数。

相比之下,使用强化学习(RL)训练的模型则表现优异,即使这些模型仅仅用数学数据进行训练,它们也能在科学问答、代码生成、甚至日常对话等任务上保持或提升性能。

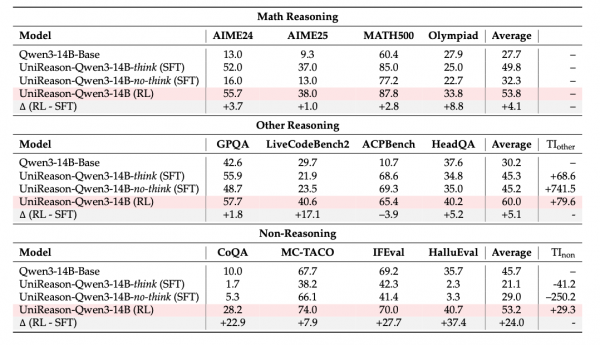

为了验证这一发现,研究团队又进行了严格的对照实验,他们选择了Qwen3-14B作为基础模型,使用相同的数学数据集,分别采用SFT和RL方法进行训练,实验结果完美复现了之前的结论。

RL训练的模型在AIME24数学竞赛中达到了55.7%的正确率,在MATH500测试集上达到87.8%,在OlympiadBench上达到33.8%,同时,它在科学推理任务GPQA上提升了1.8%,在代码生成任务LiveCodeBench上提升了17.1%。而SFT训练的模型虽然在数学任务上表现不错,但在很多非推理任务上出现了显著的性能下降。

这种差异不仅仅体现在准确率上,还表现在模型的内部表征变化上,研究团队通过主成分分析(PCA)技术,检查了模型训练前后的内部特征空间变化,发现SFT训练导致模型的内部表征发生了剧烈变化,特别是对于非推理输入。而RL训练则能够更好地保持原始模型的特征几何结构,避免了过度的表征漂移。

方法评析:深入模型“大脑”,探寻差异之源

为了理解SFT和RL训练方式的本质差异,研究团队采用了多层面的分析方法,他们不仅关注模型的最终性能,还深入分析了训练过程中模型内部发生的变化。

SFT和RL的训练机制确实存在根本性差异,SFT方法直接使用高质量的推理轨迹作为训练目标,模型学习模仿这些"标准答案"。这种方法看似直接,但实际上容易导致模型过度拟合特定的推理模式,研究团队发现,SFT训练的模型在token分布上发生了较大变化,许多与推理无关的词汇的使用概率也被改变了。

RL方法则采用了不同的策略,它不直接给出标准答案,而是通过奖励信号引导模型探索和优化,研究团队使用答案正确性作为奖励信号,让模型在保持原有能力的基础上,逐步提升数学推理表现,这种方法的优势在于,它不会强制模型改变所有的行为模式,而是在保持原有能力的基础上进行有针对性的改进。

通过词汇分布分析,研究团队发现了两种训练方法的另一个重要差异,RL训练的模型只会改变少数与任务相关的词汇使用模式,比如在数学推理任务中,它会增加使用"定义"、"计算"、"数字"等逻辑相关词汇的频率。而SFT训练的模型则会改变大量词汇的使用模式,包括许多与任务无关的词汇,这种广泛的变化可能是导致其他任务性能下降的原因。

最有说服力的证据来自于模型内部表征的分析,研究团队使用PCA技术,量化了模型在不同层次上的表征变化。他们发现,SFT训练导致模型内部表征发生了显著漂移,平均漂移距离达到40.4(数学任务)、13.9(其他推理任务)和129.8(非推理任务)。而RL训练的模型漂移距离仅为8.5、3.5和36.9,显著小于SFT模型。

这种差异也体现在token排名变化上,研究团队分析了模型生成的token在原始模型词汇表中的排名变化,SFT模型平均有10.6个token的排名发生了变化,而RL模型仅有0.98个,这表明RL训练对模型原有的语言生成模式干扰更小。

不过,这项研究也存在一些局限性,实验主要集中在中等规模的模型上,对于更大规模模型的情况还需要进一步验证。而且研究使用的数学数据集也相对有限,只有47000个样本,对于更大规模数据的情况可能会有不同的结论。

此外,RL训练的计算成本相对较高,这可能也限制其在实际应用中的推广。

结论:告别“刷题内卷”,拥抱真正的“能力迁移”

我们应该如何定义和衡量AI的"智能"?

如果一个模型在数学推理上表现出色,但在常识推理或语言理解上表现糟糕,我们能说它更"聪明"吗?这项研究提供的能力迁移性指数为我们提供了一个新的评估维度,有助于更全面地评估AI模型的能力。

很显然,提升AI在特定任务上的表现和提升AI的通用能力是两个不同的目标,需要采用不同的训练策略。

如果目标是开发一个专门的数学推理模型,那么SFT方法可能是合适的选择,但如果希望模型在保持数学推理能力的同时,还能在其他任务上表现良好,那么RL方法显然是更好的选择。

这项工作对整个大模型的研究和应用社区都具有重要的指导意义,它提醒模型开发者,需要重新审视和优化后训练(post-training)的方式,特别是减少对SFT蒸馏数据的过度依赖 。未来,探索SFT和RL更有效的结合方式,或者设计出能够更好保留通用能力的SFT变体,将是极具价值的研究方向。而对于模型的使用者来说,在选择模型时,不应只看其在某个单一榜单上的排名,而应更全面地考察其在多样化任务上的综合表现。

毕竟,我们的目标是创造出能够理解世界、解决复杂问题的通用人工智能,而不是一个个在细分领域里“内卷”的“刷题机器”,这篇论文,正是朝这个更宏伟目标迈出的坚实一步。

至顶AI实验室洞见

这项研究的结论其实很像我们日常生活中的教育哲学,授人以鱼不如授人以渔。

SFT就像一个填鸭式的老师,把解题的每一步都写在黑板上,要求学生一字不差地背下来。这种“授人以鱼”的方式,或许能让学生在模拟考中取得高分,但一旦遇到新题型就束手无策。

而RL则更像一位苏格拉底式的导师,它不给标准答案,只在你走对方向时给予肯定,鼓励你自己去探索、去思考、去总结,这种“授人以渔”的模式,才能真正培养出举一反三、触类旁通的能力。

随着我们向真正的通用人工智能迈进,我们可能需要更多地思考如何设计能够培养模型"自主学习能力"的训练范式,而非简单地增加训练数据量或模型参数,这种从"授鱼"到"授渔"的范式转变,可能是实现真正强大且灵活的人工智能的关键路径。

毕竟,在真实世界中,最有价值的不是能回答已知问题的智能,而是能够处理前所未见情境的智能。

论文地址:

https://arxiv.org/pdf/2507.00432

END

本文来自至顶AI实验室,一个专注于探索生成式AI前沿技术及其应用的实验室。致力于推动生成式AI在各个领域的创新与突破,挖掘其潜在的应用场景,为企业和个人提供切实可行的解决方案。

Q&A:

Q: 数学能力强的AI模型通用能力是不是更强?

A: 不是。卡内基梅隆大学的研究发现,数学能力优异的模型在其他任务上表现平平,甚至还不如未加强数学推理能力的原始模型,这说明数学能力并不等于通用能力。关键在于训练方法:使用监督微调(SFT)的模型虽然数学推理表现优异,但在非推理任务上大幅下降;而使用强化学习(RL)的模型能在提升数学能力的同时保持其他任务的性能。

Q: 现在评估AI模型的标准有没有问题?

A: 有问题。目前过度依赖AIME、MATH等数学推理榜单来评估模型能力,这种单一维度评估可能误导我们对AI"智能"的理解。一个在数学上表现出色但在常识推理上糟糕的模型,不能算真正"聪明"。未来应该采用更全面的评估体系,关注模型在多样化任务上的综合表现,而不是只看某个细分榜单的排名。

Q: 什么是"能力迁移指数",怎么衡量AI的能力迁移?

A: 能力迁移指数是卡内基梅隆大学提出的量化指标,用来衡量模型从数学推理到其他任务的能力迁移程度。计算方法是比较模型在数学任务上的提升幅度与在其他任务上的表现变化。如果模型在数学上提升30%,在其他推理任务上也提升30%,迁移性指数就是100%,表示完美迁移。SFT训练的模型迁移性指数甚至是负数,而RL训练的模型表现优异。

好文章,需要你的鼓励

CoreWeave LOTA技术实现对象数据高速全球传输

CoreWeave发布AI对象存储服务,采用本地对象传输加速器(LOTA)技术,可在全球范围内高速传输对象数据,无出口费用或请求交易分层费用。该技术通过智能代理在每个GPU节点上加速数据传输,提供高达每GPU 7 GBps的吞吐量,可扩展至数十万个GPU。服务采用三层自动定价模式,为客户的AI工作负载降低超过75%的存储成本。

IDEA研究院等机构联手打造智能AI助手:让机器像人类一样思考和学习的突破性技术

IDEA研究院等机构联合开发了ToG-3智能推理系统,通过多智能体协作和双重进化机制,让AI能像人类专家团队一样动态思考和学习。该系统在复杂推理任务上表现优异,能用较小模型达到卓越性能,为AI技术的普及应用开辟了新路径,在教育、医疗、商业决策等领域具有广阔应用前景。

谷歌DeepMind与CFS合作开发核聚变等离子体AI控制系统

谷歌DeepMind与核聚变初创公司CFS合作,运用先进AI模型帮助管理和改进即将发布的Sparc反应堆。DeepMind开发了名为Torax的专用软件来模拟等离子体,结合强化学习等AI技术寻找最佳核聚变控制方式。核聚变被视为清洁能源的圣杯,可提供几乎无限的零碳排放能源。谷歌已投资CFS并承诺购买其200兆瓦电力。

AI训练新突破:上海AI实验室让大模型自己当老师,推理和判断能力同步飞跃

上海人工智能实验室提出SPARK框架,创新性地让AI模型在学习推理的同时学会自我评判,通过回收训练数据建立策略与奖励的协同进化机制。实验显示,该方法在数学推理、奖励评判和通用能力上分别提升9.7%、12.1%和1.5%,且训练成本仅为传统方法的一半,展现出强大的泛化能力和自我反思能力。

Littelfuse推出首款具有SPDT和长行程且兼容回流焊接的发光轻触开关

至顶科技助力AI创业者,在HICOOL峰会探索“如何用AI赚到第一桶金”

CoreWeave LOTA技术实现对象数据高速全球传输

谷歌DeepMind与CFS合作开发核聚变等离子体AI控制系统

微软为Windows 11推出全新Copilot自动化功能

苹果研究人员探索AI如何预测Bug、编写测试并修复代码

刚果称全球最大水电站可为AI数据中心供电

HPE Alletra存储业务获得战略重点关注

谷歌DeepMind与核聚变初创公司合作的真实原因

Omdia预测:超大规模云市场销售额2030年将达1630亿美元

Oracle全面押注AI,用户仍在摸索应用路径

Aramex与AWS携手推进全球物流数字化转型

调研了300家企业,ICONIQ 发布《开发者手册:2025年AI现状报告》,揭秘企业AI落地的全景路线

里通义开源音频生成模型,能模仿音效师为视频配音

216年过去了,人类离攻克癌症还有多远?AI医疗或许会是那个“破局者”

MIT新框架让AI模型具备自我学习和持续适应能力

MiniMax-M1开源模型发布:百万级上下文窗口与超高效强化学习

夸克发布首个可生成完整志愿报告的Agent

KO 满血版DeepSeek?AM-Thinking-V1,32B干翻一众千亿级大模型

字节Seed团队绝地翻盘,发现多模态模型也有涌现时刻,开源BAGEL模型

打造“全球一朵云”,广汽迈入出海3.0时代

大模型应该怎么用?我们大多数人都错了,微软最新研究:大模型对话次数越多,性能越差