你是否厌倦了各种AI炒作?

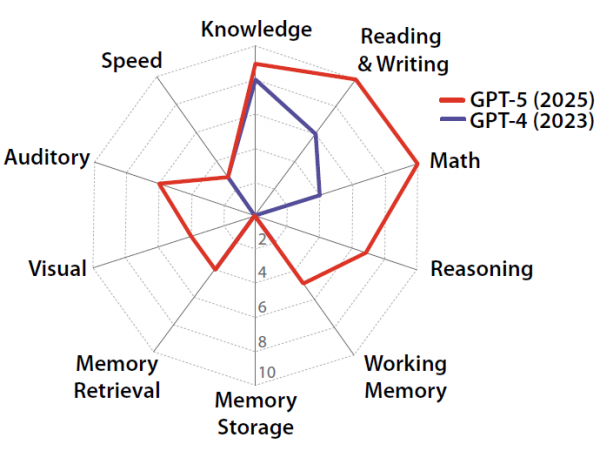

2025年10月21日,来自斯坦福大学、MIT、加州大学伯克利分校等全球29所顶尖研究机构的学者共同完成研究,首次建立了量化评估AGI的完整框架。研究基于心理学权威的CHC理论,将通用智能分解为10个可测量的认知领域,每个领域占10%,总分100%代表达到人类认知水平。测试结果显示,GPT-4得分27%,GPT-5得分58%,呈现出"锯齿状"能力分布,在知识和语言方面接近满分,但长期记忆存储为零分。

想象一下,你去医院做体检,医生不仅要测血压、验血,还要检查心肺功能、视力听力、反应速度等等。只有各项指标都合格,才能说你身体真正健康。同样的道理,这个研究团队认为,要判断一个AI是否真正"聪明"到了人类的水平,也需要这样一套全面的检查标准。他们给这个目标起了个名字:AGI,也就是"通用人工智能"。

什么是通用人工智能呢?简单说,就是一个AI不仅能下棋、不仅能写文章,而是能像一个受过良好教育的成年人那样,面对各种各样的认知任务都游刃有余。就像一个全科医生,不是只会看感冒或只会做手术,而是各科都懂一些,能应对大部分病症。

可问题来了:怎么判断一个AI是否达到了这个标准呢?以前,科学家们对AGI的定义非常模糊,就像大家都说"聪明",但每个人心里对"聪明"的标准可能完全不同。有人觉得会下围棋就很聪明,有人觉得会写诗才算聪明。这种模糊性给研究和评估带来了巨大困扰,你无法衡量一个东西,就很难知道我们离目标还有多远。

这就是这篇论文的重要性所在。研究团队决定,不再满足于含糊其辞的定义,而是要建立一套可以打分的标准,就像我们的体检报告会给每项指标一个具体数值一样。他们的思路很巧妙:既然人类是目前唯一拥有"通用智能"的生物,那就参照人类大脑的运作方式来设计测试。

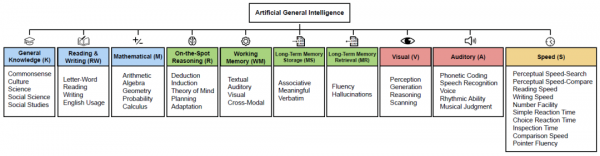

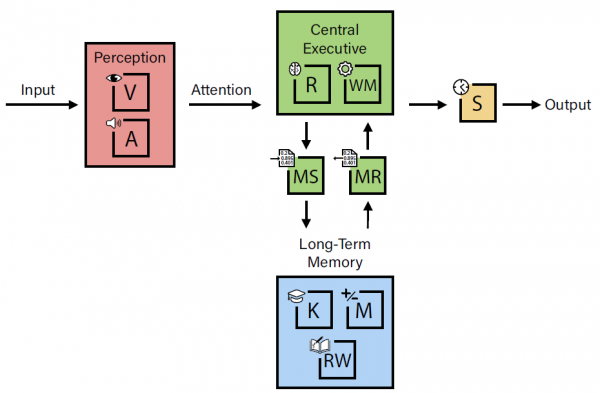

为了做到这一点,研究团队借鉴了心理学领域最权威的智力理论——CHC理论(Cattell-Horn-Carroll理论)。这个理论是心理学家花了一百多年时间,通过大量实验和数据分析总结出来的,基本上把人类的智能拆解成了各个可测量的部分,就像把一台复杂的机器拆成零件一样。这个理论的优势在于,它不是拍脑袋想出来的,而是基于大量真实数据验证过的。事实上,现在几乎所有主流的智力测试,都是按照CHC理论的框架设计的。

基于这个理论,研究团队把"通用智能"分成了十个大类,每个大类占10分,总分100分。这就像体检有十个大项目一样。这十个认知领域涵盖了从知识储备、语言能力、数学能力到记忆力、反应速度等各个方面。他们给这个评分系统起名叫"AGI分数",100分就代表完全达到了人类的认知水平。

现在到了最激动人心的部分:当研究团队用这套标准去测试当前最先进的AI系统,比如GPT-4和GPT-5时,结果却让人大吃一惊。

如果你以为GPT-4或GPT-5这样的顶级AI会在各项测试中都接近满分,那你可能要失望了。GPT-4的总分只有27分(满分100),GPT-5也只有58分。更令人惊讶的是,这些分数的分布极不均匀,就像一个学生偏科严重,有的科目接近满分,有的科目却是零分。

研究团队把这种现象形象地称为"锯齿状"能力分布。想象一把锯子,锯齿有高有低,参差不齐。GPT-5在某些领域的表现确实令人印象深刻,比如在知识储备、阅读写作、数学能力上都能拿到9-10分(满分10分)。这就好比一个学霸,语文数学历史都考90多分。但是,同样是这个"学霸",在长期记忆存储这一项上却得了零分,完全不及格!

这是什么概念呢?就好比一个人记忆力超强,能背诵整本百科全书,但只要你和他聊完天转身离开,第二天他就完全不记得你说过什么。每次见面都像第一次见面一样,需要重新介绍自己。这种"健忘症"对于一个号称智能的系统来说,简直是致命缺陷。

为什么会出现这种奇怪的现象呢?研究团队发现,当前的AI系统其实是在用它的强项来弥补弱项,这种策略被他们称为"能力扭曲"。打个比方,就像一个没有长期记忆的人,为了应付日常生活,不得不随身带着一个巨大的笔记本,把所有信息都记在上面。虽然表面上看起来他能"记住"很多事,但实际上他只是在不停地翻笔记本,而不是真的记在脑子里。

这种补偿策略在短期内看起来有效,但实际上既低效又脆弱。就像那个随身带笔记本的人,一旦笔记本丢了或者信息太多翻不过来,整个系统就崩溃了。对AI来说,这意味着它们虽然看起来能处理很多任务,但一旦遇到真正需要持续学习、积累经验的场景,就会暴露出严重的局限性。

那么,研究团队具体是如何测试这十个认知领域的呢?让我们像参观一个大型体检中心一样,逐一了解每个检查项目。

第一站是"知识储备"检查室。这里测试的是AI掌握了多少常识、科学知识、社会知识和历史文化。就像问一个人:"你知道月球为什么总是同一面朝向地球吗?""美国总统是谁?""二战是怎么结束的?"这些都是受过良好教育的成年人应该知道的基本知识。测试结果显示,GPT-4在这方面得了8分(满分10分),GPT-5得了9分。这说明这些AI确实"读过很多书",知识面相当广泛。

第二站是"读写能力"检查室。这里不仅测试AI能否读懂复杂文章,还要看它能否写出组织清晰、逻辑严密的文字。比如给它一篇长达几千字的产品说明书,问"这个产品的保修期是多久?"或者让它写一篇关于"远程工作利弊"的文章。结果显示,GPT-4在这方面得了6分,GPT-5则提升到了10分。这意味着最新的AI在理解和生成文字方面已经达到甚至超越了人类平均水平。

第三站是"数学能力"检查室。这里的测试从简单的算术一直到微积分,涵盖了代数、几何、概率论等各个数学分支。比如会问:"一个公司最初有200名员工,每月新增20人,每人月薪4000美元,三个月后总工资支出是多少?"或者更复杂的几何问题。GPT-4在这里只得了4分,而GPT-5则跃升到了满分10分,说明新一代AI在数学能力上有了质的飞跃。

第四站是"即时推理"检查室,这里测试的是AI面对全新问题时的思考能力。注意,这不是靠背答案能解决的,而是需要临场分析、推理、规划。比如给AI一个逻辑谜题:"大卫认识张先生的朋友杰克,杰克认识大卫的朋友林女士。认识杰克的人都有硕士学位,认识林女士的人都来自上海。那么谁既来自上海又有硕士学位?"这需要AI像侦探一样,根据线索一步步推理出答案。GPT-4在这方面得了零分!而GPT-5得了7分,有了显著进步,但仍然不完美。

第五站是"工作记忆"检查室。工作记忆就像电脑的内存,是你正在处理信息时的临时存储空间。比如测试会给AI展示一串数字[10, 20, 30],然后要求"先在末尾加上40,再把整个列表倒序"。或者给AI看一组图片,过一会儿再问"刚才那组图里哪个飞机也出现在了现在这组图里?"GPT-4得了2分,GPT-5得了4分,说明在这方面还有较大提升空间。

第六站是"长期记忆存储"检查室。这是检测的重灾区!长期记忆存储是指能否把新学到的东西长久地记在"脑子里",以便将来使用。比如今天你教AI认识了三个新朋友的名字和爱好,两天后再问它"还记得那个喜欢园艺的人叫什么名字吗?"结果,无论GPT-4还是GPT-5,在这一项上都是零分!这就像一个每天早上醒来都会失忆的人,虽然他很聪明,但无法积累经验,无法真正成长。

第七站是"长期记忆检索"检查室。这测试的是AI能否快速准确地从它已有的知识库中调取信息,以及最关键的:它会不会"编造"不存在的信息。比如问"拿破仑在南非战役中使用了什么关键战略?"正确答案应该是"拿破仑从未在南非作战,这个问题本身有误"。但如果AI信口开河编造一个答案,就说明它的记忆检索存在严重问题。这种"编造"在AI领域被称为"幻觉"。GPT-4和GPT-5在快速检索方面都得了4分,说明速度还可以,但在避免幻觉方面都是零分,意味着它们经常会自信满满地说出错误信息。

第八站是"视觉处理"检查室。现代AI应该能"看懂"图片和视频。测试包括识别图片内容、给图片写说明、判断视觉上的异常、甚至创造新图片等。比如给AI看一张扭曲的图片问"这是什么动物?"或者让它生成一张"金毛猎犬在公园玩耍"的图片。GPT-4因为完全不具备视觉能力得了零分,而GPT-5得了4分,说明有了基本的视觉能力,但还远不够完善。

第九站是"听觉处理"检查室。这里测试AI能否理解语音、识别音乐节奏、判断音调高低等。比如播放一段话让AI转写成文字,或者播放两段节奏问"这两段节奏一样吗?"同样,GPT-4得了零分,GPT-5得了6分,表现比视觉处理稍好一些。

最后一站是"速度"检查室。这里测试的不是AI能做什么,而是做得有多快。包括阅读速度、打字速度、反应时间等十个子项目。想象一个场景:给AI展示一大段文字,里面藏着字母"a"和"t",要它快速数出有多少个。或者突然给它一个指令"看到这句话后立即说'你好'",测试它的反应时间。结果显示,GPT-4和GPT-5在读写和简单计算方面速度尚可,各得3分,但在需要多模态处理(比如同时处理图像和声音)的速度测试中表现很差。特别是GPT-5,虽然能力更强,但因为需要"思考"的时间太长,反而拖慢了速度。

当我们把这十项测试的结果放在一起看时,就会发现一个有趣的模式:当前的AI系统并不是全面的"笨"或"聪明",而是在某些方面极其出色,在另一些方面却几乎无能。这就像一个人可能是数学天才,但却完全不会游泳、不会骑车,他的智能是"碎片化"的,而不是"通用"的。

研究团队深入分析后指出,这种不均衡背后有深层原因。首先,目前的AI训练方式决定了它们擅长处理已有的大量数据。想象一下,如果你能瞬间阅读互联网上所有的书籍、文章和网页,你当然会在知识测验中表现出色。这就是为什么GPT在知识储备、阅读理解这些"见多识广"就能做好的领域表现优秀。

但是,真正的智能不仅仅是"知道很多",更重要的是"会学习新东西"和"能灵活应用"。这就涉及到我们大脑中一些更基础的认知机制,比如长期记忆的形成、临时信息的操作、快速的模式识别等。这些能力看似简单(毕竟连小孩子都能记住昨天发生的事),但对AI来说却极其困难。

举个具体例子来说明这种差异。假设你在教AI学习一个新的工作流程。对人类来说,你可能示范几次,解释一下原理,过几天再复习一遍,这个流程就基本记住了,以后遇到类似情况能举一反三。但对当前的AI来说,要么它根本记不住(长期记忆为零),要么你得每次都把整个流程重新输入一遍(用工作记忆补偿),而且它很难判断什么时候该用这个流程,什么时候不该用(推理能力不足)。

更严重的问题是,为了弥补这些根本性缺陷,AI开发者采用了一些"曲线救国"的办法,研究团队称之为"能力扭曲"。最典型的例子就是用超大的"工作记忆"(也就是所谓的上下文窗口)来代替真正的"长期记忆"。这就好比一个人因为记不住东西,所以随身带着一个超大的背包,里面装满了笔记、文件和资料。需要什么信息就在背包里翻找。这种方法虽然表面上能工作,但效率极低,而且有严重的局限性:背包容量终究有限,翻找速度也慢,最关键的是,这样的系统永远无法真正"学习"和"成长"。

另一个补偿策略是依赖外部搜索工具。因为AI经常会"幻觉",也就是自信地说出错误信息,所以现在的解决办法是给它配上互联网搜索功能,需要什么信息就实时去网上查。这又像一个人虽然记忆力很差,但手机网络很快,什么都可以百度。可问题是,这不是真正意义上的"记忆",只是一种外部依赖。而且这种方法无法处理私密信息、个人经历这些不在互联网上的知识。

研究团队特别强调,这些"能力扭曲"现象如果不被识别和理解,会给我们对AGI进展的判断带来严重误导。我们可能会因为AI在某些任务上表现出色,就误以为它已经很接近通用智能了,但实际上它只是在用各种补偿策略掩盖根本性的认知缺陷。这就好比一个只会爬行的机器人,通过安装各种辅助轮子和支撑架,看起来能"走路"了,但本质上它还是不会真正的双足行走。

为了帮助我们更直观地理解这些发现,研究团队提出了一个精妙的类比:把智能系统想象成一台高性能发动机。

一台发动机的总功率(相当于整体智能水平)取决于它所有零部件的配合。即使你有世界上最好的活塞、最先进的燃油喷射系统,只要有一个关键部件严重故障,比如冷却系统完全失效,整台发动机的性能就会被拖垮,甚至根本无法运转。

当前的AI系统就像一台有着超强涡轮增压器(知识储备)、高效变速箱(语言处理)、精密电子控制系统(数学能力)的发动机,但它的冷却系统(长期记忆)和润滑系统(记忆检索)却几乎不存在。短期内,通过各种临时措施,比如不停地浇冷水降温、频繁更换零件,这台发动机也许能勉强运转,但它永远无法真正发挥应有的性能,也无法长时间稳定工作。

这个类比还揭示了另一个重要洞察:智能的各个部分不是孤立的,而是高度相互依赖的。比如说,即使你数学能力再强(数学能力10分),如果推理能力跟不上(推理能力低分),你可能连复杂的数学应用题都做不好,因为你不知道该用哪个公式、按什么步骤解题。再比如,理解一部电影需要同时调用视觉处理(看画面)、听觉处理(听对白)、工作记忆(记住剧情)和推理能力(理解人物动机)。如果其中任何一环较弱,整体理解就会大打折扣。

从这个角度看,当前AI的58分(GPT-5)虽然看起来"及格"了,但因为有几个关键部件是零分,这台"发动机"实际上还远远谈不上是一台真正的"通用智能"发动机。它更像是一台特殊用途的机器,在某些特定赛道上跑得飞快,但换个环境就完全不行了。

读到这里,你可能会想:那又怎么样呢?这些技术细节离我们普通人的生活很远吧?其实不然。这项研究的发现对我们理解和使用AI有着非常实际的意义。

首先,它帮助我们建立正确的预期。现在各种媒体经常报道"AI要超越人类了"、"AGI即将来临"这样的标题。但这项严谨的研究告诉我们,即使是最先进的AI系统,离真正的通用智能还有很长的路要走。它们虽然在某些方面表现惊人,但在很多人类认为理所当然的基础能力上还有巨大缺陷。了解这一点,我们就能更理性地看待AI技术的发展进程,既不过度恐慌也不盲目乐观。

其次,它指明了AI研究的关键突破方向。过去,研究人员可能会认为只要不断增加训练数据、扩大模型规模,AI就会越来越"聪明"。但这项研究清楚地表明,单纯的规模扩大是不够的,必须要解决一些根本性的架构问题,特别是长期记忆机制。这就好比建造摩天大楼,如果地基有问题,楼层盖得再高也是危险的。研究团队指出,解决长期记忆问题可能需要全新的技术方案,比如动态调整模型参数的机制,让AI能够像人类一样通过不断的经历来"成长"。

第三,它对AI的实际应用有重要指导意义。比如,既然我们知道当前AI的长期记忆几乎为零,在设计AI产品时就要特别注意这一点。你不能指望一个AI助手今天和你深入讨论了一个项目方案,明天就能主动记起来继续推进,除非你每次都重新告诉它所有背景信息。了解这些局限性,能帮助我们更好地设计人机协作的工作流程,扬长避短。

第四,这项研究还提醒我们关注AI的"幻觉"问题。当AI自信满满地告诉你一个信息时,它很可能是在"编造"而不是真的"知道"。就像研究中提到的,GPT们在避免幻觉方面都是零分。这意味着在使用AI时,我们必须保持批判性思维,特别是在做重要决策时,不能完全依赖AI提供的信息,而要进行独立验证。

最后,从更宏观的角度看,这项研究揭示了"智能"这个概念的复杂性和多面性。我们往往会简单地说某个人或某个AI"聪明"或"不聪明",但实际上智能包含许多不同的维度。一个在知识竞赛中表现出色的人,可能在需要快速反应的运动中表现平平;一个擅长数学的人,可能在人际交往中比较笨拙。承认这种多样性,能帮助我们更全面地评价和发展智能,无论是人类的还是人工的。

这篇论文最大的贡献不是告诉我们AI有多强或多弱,而是给了我们一把真正的尺子,让我们能够客观、具体地衡量AI的智能水平。有了这把尺子,我们就不会被各种炒作或恐慌所左右,而是能够基于事实来讨论AI的现状和未来。

这种清晰性对于AI这个影响深远的技术领域来说,再重要不过了。毕竟,只有先搞清楚"我们在哪里",才能更好地规划"我们要去哪里"以及"我们该怎么去"。而这,正是这项研究为整个AI领域带来的宝贵礼物。

本文来自至顶AI实验室,一个专注于探索生成式AI前沿技术及其应用的实验室。致力于推动生成式AI在各个领域的创新与突破,挖掘其潜在的应用场景,为企业和个人提供切实可行的解决方案。

Q1:AGI分数58%是什么意思?是不是说AI已经完成了一半的进化?

A:不能这么简单理解。58%不是说AI"完成了一半",而是说在十个认知领域的测试中,平均得到了58分(满分100)。更关键的是,这个分数分布极不均匀,有些领域接近满分,有些领域却是零分。就像一个学生虽然总分及格了,但其实有好几门课是零分,这样的"及格"其实问题很大。

Q2:为什么长期记忆存储这么重要?AI没有它不是也能工作吗?

A:确实,当前的AI通过各种补偿策略(比如超大的上下文窗口)可以勉强工作,但缺少长期记忆就像一个人每天醒来都会失忆一样,无法真正学习和成长。你和它交流过的所有内容,解决过的所有问题,一旦超出它的"工作记忆"范围就会被遗忘。这意味着它永远无法积累经验、建立深度关系或真正理解上下文背景。

Q3:这项研究对普通人使用ChatGPT这类AI有什么实际影响?

A:主要影响是帮助我们建立正确的预期。比如,不要期待AI能记住你上次对话的内容(除非在同一个会话中);在重要决策时要验证AI提供的信息,因为它可能会"幻觉"编造内容;要理解AI虽然知识丰富,但在需要多步推理或灵活应变的任务中可能表现不佳。了解这些局限能帮你更有效地使用AI工具。